Không chỉ nhu cầu chip GPU phục vụ quá trình huấn luyện những thuật toán deep learning và trí thông minh nhân tạo có dấu hiệu tăng, mà những chip nhớ công nghệ HBM (High Bandwidth Memory) cũng đang tăng giá đến mức chóng mặt. Bằng chứng là các nhà sản xuất chip DRAM đã nâng giá bán chip HBM phục vụ trong những hệ thống nghiên cứu AI.

BusinessKorea đưa tin, những con chip RAM HBM do SK Hynix và Samsung sản xuất đã tăng giá khá cao, cá biệt RAM HBM3 hiện giờ giá đã gấp 5 lần so với những chip DRAM tiêu dùng tốc độ cao nhất hiện tại.

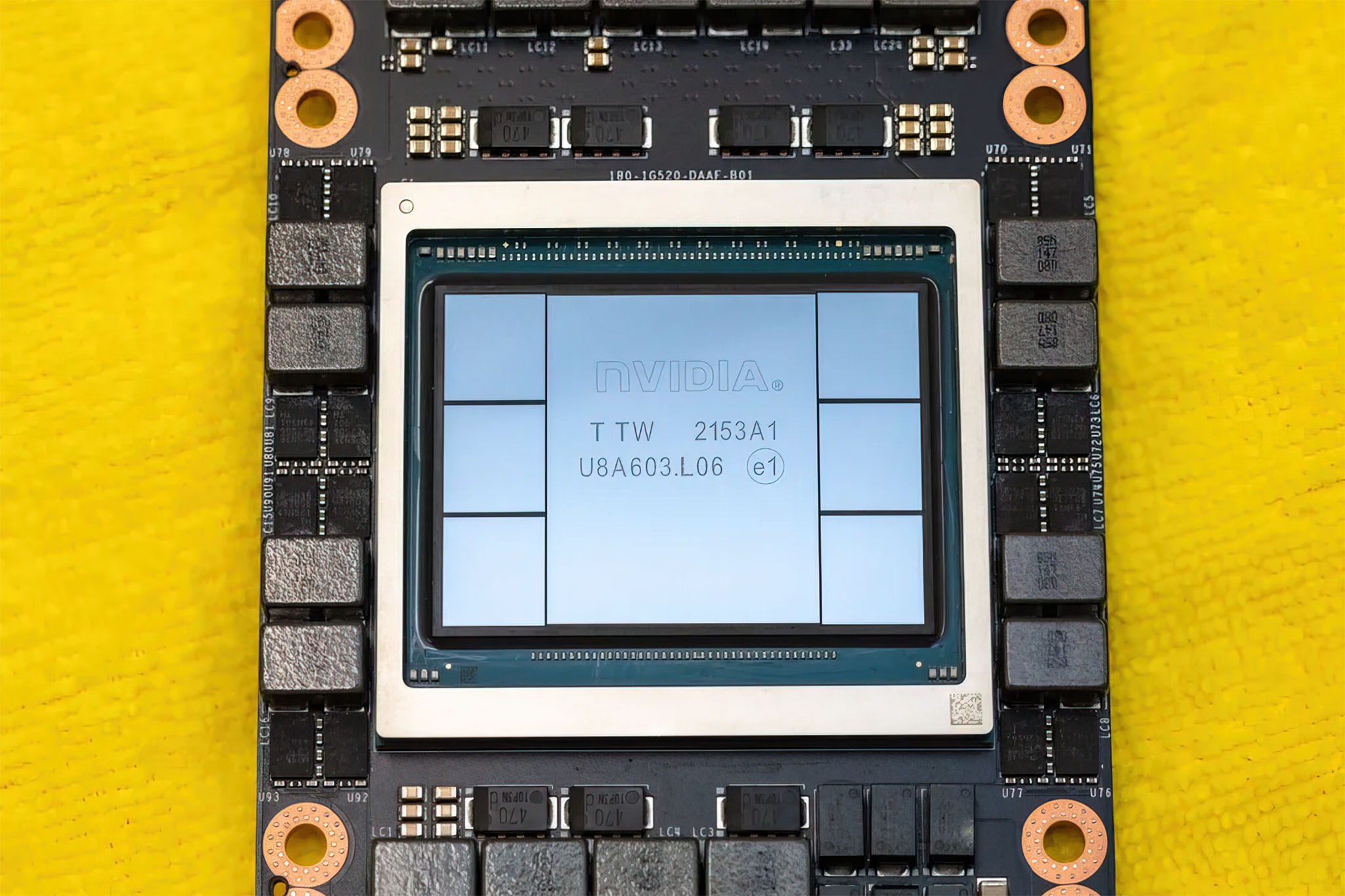

Bản thân Nvidia cũng đã đề nghị SK Hynix tăng sản lượng chip HBM3 để đủ đáp ứng nhu cầu thị trường. Cùng lúc, những đơn vị khác như Intel cũng đang tìm cách ứng dụng HBM3 với băng thông bộ nhớ tối đa lên đến 819 GB/s. Hoàn toàn có khả năng SK Hynix sẽ không đáp ứng kịp nhu cầu của các đối tác.

BusinessKorea viết: “Sự ra mắt của ChatGPT đã tạo ra cơ hội lớn cho những nhà sản xuất chip nhớ bán dẫn của Hàn Quốc. ChatGPT có quy trình học dựa vào khối lượng dữ liệu khổng lồ thông qua thuật toán AI, từ đó trả lời câu hỏi của con người theo cách tự nhiên nhất. Vì thế tốc độ xử lý dữ liệu đã trở thành yếu tố quan trọng để tạo ra hiệu năng xử lý mô hình ngôn ngữ tốt và nhanh hơn. Và hiện tại toàn bộ những con chip nhớ phục vụ các hệ thống trung tâm dữ liệu vận hành AI đều được các công ty Hàn Quốc sản xuất.”

Kể cả những chuẩn HBM và HBM2, vốn được trang bị trên những mẫu GPU phục vụ nghiên cứu AI kiến trúc cũ như Ampere và Volta cũng tăng giá, vì bản thân những kiến trúc cũ này vẫn tạo ra hiệu năng xử lý machine learning đáng nể. Về mặt thị phần, SK Hynix hiện tại đang chiếm từ 60 đến 70% thị phần chip RAM HBM.