Chip Azure Maia 100 và Cobalt 100 là hai chip bán dẫn đầu tiên được Microsoft thiết kế cho cơ sở hạ tầng đám mây của mình.

Tin đồn đã đúng. Microsoft chính thức nhảy vào làm chip AI tùy chỉnh của riêng mình, có thể được sử dụng để đào tạo các mô hình ngôn ngữ lớn và có khả năng tránh được sự phụ thuộc tốn kém vào Nvidia. Microsoft đã phát triển CPU dựa trên kiến trúc ARM phục vụ cho hạ tầng đám mây. Cả hai chip tùy chỉnh của Microsoft đều được thiết kế để cung cấp cho các trung tâm dữ liệu Azure và giúp công ty cũng như khách hàng doanh nghiệp sẵn sàng cho một tương lai tràn ngập AI.

Theo The Verge, hai chip Azure Maia AI của Microsoft và CPU Azure Cobalt chạy bằng kiến trúc ARM sẽ ra mắt vào năm 2024. Hiện nay, nhu cầu mua GPU H100 của Nvidia dùng đào tạo và vận hành các công cụ hình ảnh tổng hợp và mô hình ngôn ngữ lớn đang tăng lên rất cao. Nhu cầu về những GPU này cao đến mức một số thậm chí đã bán được với giá hơn 40.000 USD (940 triệu đồng) trên eBay.

Rani Borkar, người đứng đầu hệ thống phần cứng và cơ sở hạ tầng Azure tại Microsoft, giải thích trong một cuộc phỏng vấn với The Verge: “Microsoft thực sự có lịch sử lâu dài trong việc phát triển chip. Microsoft đã hợp tác sản xuất chip cho Xbox hơn 20 năm trước và thậm chí còn đồng thiết kế chip cho các thiết bị Surface của mình.

Rani Borkar nói: “Những nỗ lực làm chip hiện nay được xây dựng dựa trên kinh nghiệm đó. Vào năm 2017, chúng tôi đã bắt đầu kiến trúc hệ thống phần cứng đám mây và bắt đầu hành trình đưa chúng tôi đi đúng hướng để xây dựng các chip tùy chỉnh mới của mình.”

Chip AI Azure Maia mới và CPU Azure Cobalt đều được xây dựng nội bộ tại Microsoft, kết hợp với việc đại tu sâu toàn bộ hệ thống máy chủ đám mây để tối ưu hóa hiệu suất, sức mạnh và chi phí. Rani Borkar cho biết: “Chúng tôi đang xem xét lại cơ sở hạ tầng đám mây cho kỷ nguyên AI và tối ưu hóa mọi lớp của cơ sở hạ tầng đó theo đúng nghĩa đen”.

CPU Azure Cobalt là một con chip 128 lõi được xây dựng trên thiết kế CSS của ARM Neoverse và được tùy chỉnh riêng cho Microsoft. Nó được thiết kế để cung cấp sức mạnh tính toán cho các dịch vụ đám mây nói chung trên Azure. Rani Borkar giải thích: “Chúng tôi đã suy nghĩ rất nhiều để không chỉ làm cho nó có hiệu suất cao mà còn đảm bảo rằng chúng tôi quan tâm đến việc quản lý năng lượng. Chúng tôi đã thực hiện một số lựa chọn thiết kế có chủ ý, bao gồm khả năng kiểm soát hiệu suất và mức tiêu thụ điện năng trên mỗi lõi và trên từng máy ảo.”

Microsoft hiện đang thử nghiệm CPU Cobalt của mình trên các khối lượng công việc như Microsoft Teams và máy chủ SQL, với kế hoạch cung cấp máy ảo cho khách hàng vào năm tới cho nhiều khối lượng công việc khác nhau. Mặc dù Rani Borkar không bị so sánh trực tiếp với các máy chủ Graviton 3 của Amazon có sẵn trên AWS, nhưng sẽ có một số mức tăng hiệu suất đáng chú ý so với các máy chủ dựa trên ARM mà Microsoft hiện đang sử dụng cho Azure. Borkar cho biết: “Thử nghiệm ban đầu của chúng tôi cho thấy hiệu suất của chúng tôi tốt hơn tới 40% so với hiệu suất hiện tại ở các trung tâm dữ liệu sử dụng máy chủ ARM thương mại”. Microsoft chưa chia sẻ thông số kỹ thuật hoặc điểm chuẩn đầy đủ của hệ thống.

Trình tăng tốc AI Maia 100 của Microsoft được thiết kế để chạy các khối lượng công việc AI trên đám mây, chẳng hạn như đào tạo và suy luận mô hình ngôn ngữ lớn. Nó sẽ được sử dụng để hỗ trợ một số khối lượng công việc AI lớn nhất của công ty trên Azure, bao gồm cả các phần trong mối quan hệ đối tác trị giá hàng tỷ đô la với OpenAI, nơi Microsoft hỗ trợ tất cả khối lượng xử lý của OpenAI. Gã khổng lồ phần mềm đã hợp tác với OpenAI trong các giai đoạn thiết kế và thử nghiệm Maia.

Sam Altman, Giám đốc điều hành của OpenAI cho biết: “Chúng tôi rất vui mừng khi Microsoft lần đầu tiên chia sẻ thiết kế của họ cho chip Maia và chúng tôi đã làm việc cùng nhau để tinh chỉnh và thử nghiệm nó trên các mô hình của mình. Kiến trúc AI đầu cuối của Azure, hiện được tối ưu hóa cho chip Maia, mở đường cho việc đào tạo các mô hình có năng lực hơn và làm cho các mô hình đó rẻ hơn cho khách hàng của chúng tôi.”

Được sản xuất trên tiến trình 5nm của TSMC, Maia có 105 tỷ bóng bán dẫn, ít hơn khoảng 30% so với 153 tỷ bóng bán dẫn được tìm thấy trên GPU AI MI300X của AMD, đối thủ chính của Nvidia hiện nay. Rani Borkar cho biết: “Maia hỗ trợ việc triển khai lần đầu tiên các loại dữ liệu phụ 8 bit, loại dữ liệu MX, để cùng thiết kế phần cứng và phần mềm. Điều này giúp chúng tôi hỗ trợ thời gian suy luận và đào tạo mô hình nhanh hơn.”

Microsoft là thành viên của một nhóm bao gồm AMD, ARM, Intel, Meta, Nvidia và Qualcomm đang chuẩn hóa thế hệ định dạng dữ liệu tiếp theo cho các mô hình AI. Microsoft đang xây dựng dựa trên hoạt động cộng tác và mở của Dự án Điện toán Mở (OCP) để điều chỉnh toàn bộ hệ thống cho phù hợp với nhu cầu của AI.

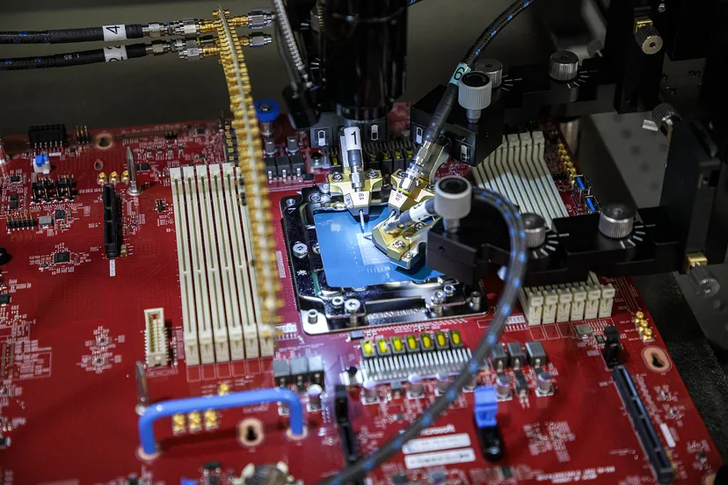

Tủ rack server Maia 100 và hệ thống làm chất lỏng

Rani Borkar tiết lộ: “Maia là bộ xử lý máy chủ làm mát bằng chất lỏng hoàn chỉnh đầu tiên do Microsoft chế tạo. Mục tiêu ở đây là cho phép mật độ máy chủ cao hơn với hiệu suất cao hơn. Bởi vì chúng tôi đang hình dung lại toàn bộ ngăn xếp nên chúng tôi chủ tâm nghĩ đến từng lớp, nên những hệ thống này thực sự sẽ phù hợp với quy mô trung tâm dữ liệu hiện tại của chúng tôi.”