Như đã đề cập trong bài tổng hợp trước, khi nói về nhu cầu GPU nghiên cứu AI đang giúp Nvidia thành công rực rỡ, những đơn vị nghiên cứu machine learning hầu hết đều phải dựa vào sức mạnh xử lý của chip chuyên biệt phục vụ nhu cầu huấn luyện thuật toán. Đó chính là lúc Nvidia phô diễn được sức mạnh công nghệ.

Và theo dự báo của nhiều nhà phân tích thị trường, rất có thể nhu cầu ứng dụng trí thông minh nhân tạo sẽ gây ra một cơn sốt GPU xử lý AI trong những tháng tới.

FierceElectronics dẫn nguồn tin cho biết, để vận hành ChatGPT, OpenAI đã phải dựa vào sức mạnh của 10 nghìn GPU của Nvidia trong quá trình huấn luyện mô hình ngôn ngữ. Nghe con số đó tưởng là đáng sợ, nhưng kể từ khi ChatGPT thu hút sự chú ý của cả thế giới, thì lượng GPU này lại trở nên hụt hơi trong quá trình phục vụ cả trăm triệu người dùng. Đó là một phần lý do OpenAI phải giới thiệu gói cước 20 USD một tháng mang tên ChatGPT Plus. Mua gói này, người dùng sẽ được ưu tiên sử dụng ChatGPT trong giờ cao điểm, cũng như dùng trước những tính năng mới cũng như AI được cải thiện hơn.

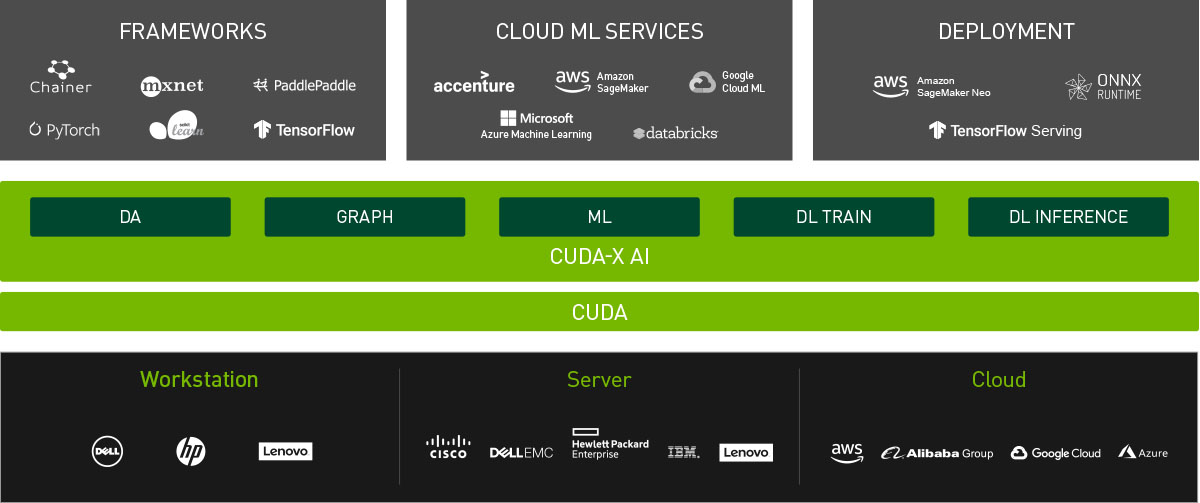

“Hoàn toàn có khả năng ChatGPT hay những mô hình deep learning khác sẽ được vận hành nhờ GPU của các hãng khác trong tương lai. Nhưng hiện giờ, GPU của Nvidia đang được sử dụng rất rộng rãi trong cộng đồng nghiên cứu và phát triển deep learning nhờ hiệu năng rất cao và khả năng hỗ trợ CUDA. Đó là một nền tảng điện toán và mô hình lập trình được chính Nvidia tạo ra, cho phép tính toán hiệu quả trên GPU của hãng. Nhiều thư viện thuật toán deep learning và framework như TensorFlow và PyTorch đều hỗ trợ CUDA, đều được tối ưu cho GPU của Nvidia," FierceElectronics viết.

Cả Microsoft lẫn Google đều đã có kế hoạch tích hợp mô hình ngôn ngữ giống ChatGPT vào công cụ tìm kiếm hay thậm chí là cả trình duyệt Edge và Chrome của họ. Tính sơ sơ sức mạnh điện toán Google cần để phục vụ tích hợp chatbot vào mọi cú tìm kiếm trực tuyến của người dùng, thì Dylan Patel của Semianalysis đưa ra con số dự đoán:

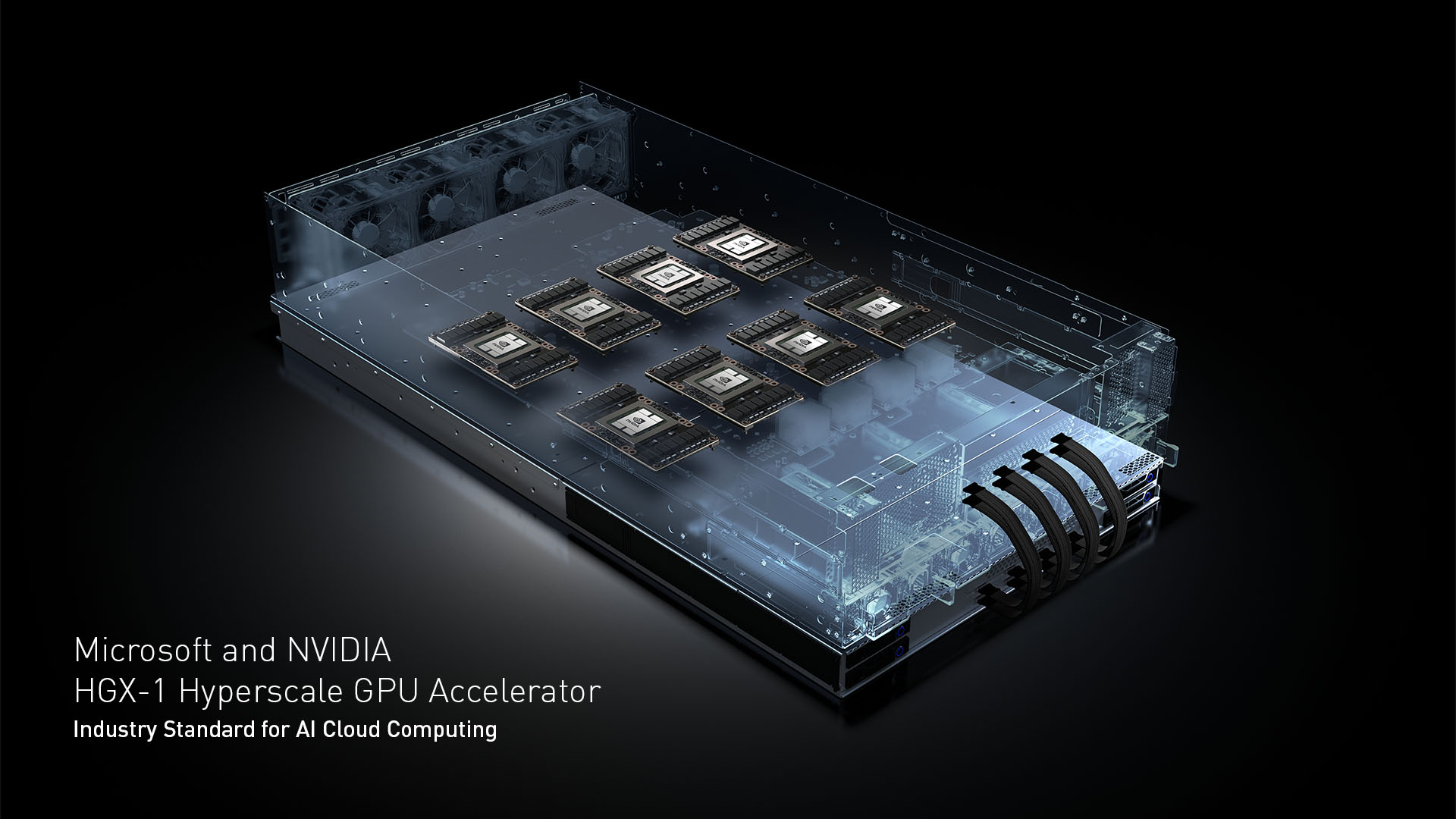

“Ví dụ ứng dụng ChatGPT cho mọi câu lệnh tìm kiếm trên Google sẽ cần 512.820 máy chủ HGX, tổng cộng 4.102.568 GPU A100 bên trong những máy chủ ấy. Tổng giá trị của chúng, cộng thêm cơ sở hạ tầng mạng vận hành có thể tiêu tốn tới 100 triệu USD vốn đầu tư, con số đó Nvidia sẽ nhận về đa số. Điều này khá chắc sẽ không thể xảy ra, mà chỉ là một ước tính vui nếu trong tương lai không có những tiến bộ vượt bậc về hiệu năng xử lý AI của phần cứng lẫn phần mềm.”

Như đã nói ở trên, trong quá trình phát triển và huấn luyện mô hình ngôn ngữ GPT-3, OpenAI dùng khoảng 10 nghìn GPU. Còn phiên bản hiện tại mà họ đang phát triển, mô hình GPT-5, có thể đang dùng tới sức mạnh của 25 nghìn GPU của Nvidia sản xuất. Ước tính trị giá toàn bộ hệ thống có thể chạm ngưỡng 225 triệu USD.

Cần nhớ, sản lượng chip bán dẫn toàn cầu là có hạn, bao gồm cả chip phục vụ doanh nghiệp lẫn người tiêu dùng. Nếu Nvidia, một tập đoàn không có fab tự gia công chip, tập trung đặt hàng GPU nghiên cứu AI, thì có thể đơn hàng GPU chơi game hay workstation sẽ bị ảnh hưởng. Đã có những thông tin nói rằng nguồn cung GPU cho máy tính để bàn trong dịp Tết Nguyên đán vừa rồi có dấu hiệu giảm.

Dù nguồn cung vẫn đang vượt nhu cầu, chí ít là đối với thế hệ GPU mới nhất, ra tiệm vẫn sẵn hàng, không bị ép giá, nhưng khả năng cầu vượt cung trong tương lai gần là điều có thể xảy ra, nhất là khi Nvidia nhìn ra tỷ suất lợi nhuận GPU nghiên cứu AI vượt xa tiềm năng của GPU máy tính để bàn, giữa thời điểm nhu cầu máy tính cá nhân đang thấp chưa từng có trong vòng 3 thập niên trở lại đây.